画像自動生成AIのStable Diffusionを始めました。

絵がへたくその私でもいい絵が描けるらしい。

どういう物かやっては見たいとは思っていたものの先延ばしにしていました。

やりたいことはだいたいやると決めているので、やっちゃおう!

しかし、私のパソコンで出来るかどうかという問題がありました。

ゲーミングパソコンでも何でもない、性能は大したことのないヤツなのです。

調べてみたところStable Diffusionの推奨スペックは、

- GPU(グラボ):VRAMが12GB以上

- メモリ:16GB以上

と書かれています。

どう見ても性能が足りません。

GeForce RTX 3060(12GB)以上のグラフィックボードが必要なのですが、

私のパソコンはGeForce RTX 1660Super(6GB)なので、性能が足りません。

新しく買うか、いったん置いておくかを考えていましたが、私のパソコンでも一応出来なくはないとの情報を見つけました。

性能が低いと、機能が制限され、画像生成の速度が遅くなるぐらいで画像生成自体は可能とのこと。

お試しでもいいのでやってみることに。

もし出来なければこれを買う予定でした。

NVIDIA GeForce RTX3060 搭載 グラフィックボード GDDR6 12GB

早速ダウンロードする

- STEP1:Pythonをダウンロード

- STEP2:Gitをダウンロード

- STEP3:Web UI(AUTOMATIC1111)をダウンロード

- STEP4:Civitaiからモデルをダウンロード

詳しい手順はシトラズムさんのHPを参照してください。

こうして環境が整いました。

いざ動かしていきましょう!

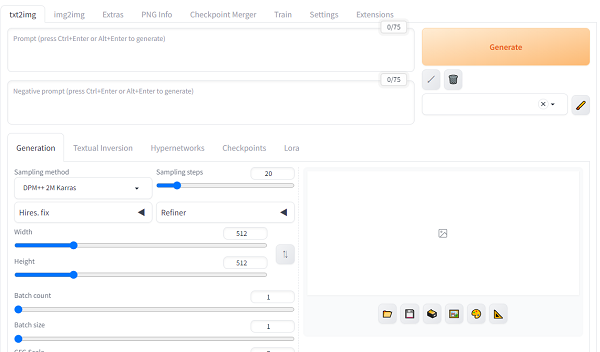

メインはこのようになっていて、プロンプトにどんな絵をかいて欲しいのかを英語で記入。

ネガティブプロンプトにはこれはダメだよという注文を書いて画像を生成する仕組みになっています。

AIへの注文が上手い人が=絵が上手い人になるのだという。

ちなみに、絵が上手い人は細部をフォトショップなどで修正できるのでより美しく、自然な画像が出来るはず。

これをやらない手はないです!

いろいろなモデルを確認しながら画像を作っていきます。

初めはこうするとどうなる?

と、実験しながらトライ&エラーでやっていきます。

今はとても面白いです。

(慣れてくると、ここが上手くいかない等イライラすると思う)

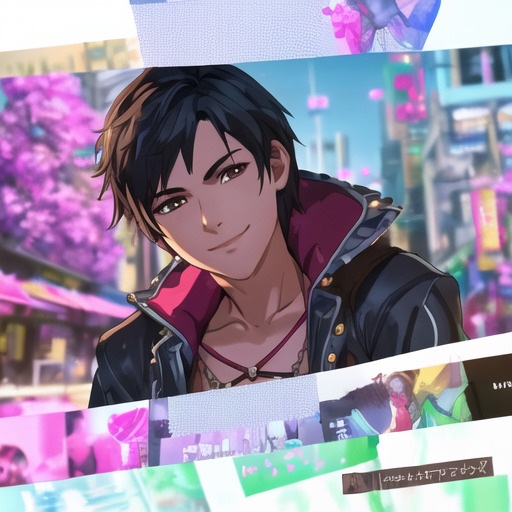

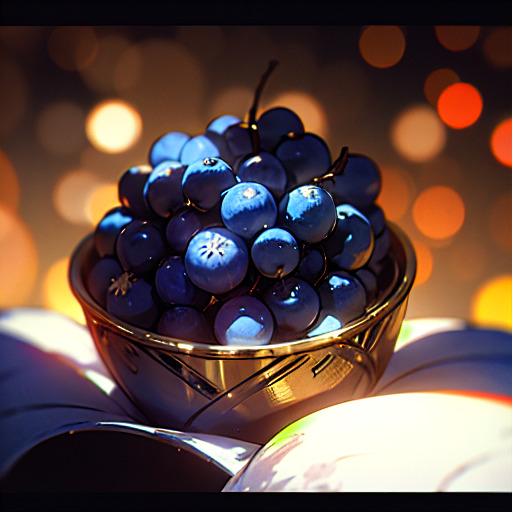

こんな感じで簡単に画像が出来ました。

(土日の時間が溶けていきましたが)

アニメ調・3DCG調・実写調・・・・・。

色んなモデルがあり、モデルを変えることによって多彩な画像が生成されます。

ただ、狙った画像が出来るという領域まではかなり長そう。

偶然に出来た良い画像を待っている状態。

特にAIは手や足の指、横顔が苦手で、気持ち悪い手が出てきたり、指が3本や6本だったり、手が3つあったりと、特に手があると厳しいので、手を描写させないように命令を書く必要があります。(上半身だけの画像が多いのはそのため)

どうしても言葉だけではイメージが伝わらないことは、人間相手でもあります。

ましてはAI相手ではさらにあります。

空を飛んでいる人を描きたいけれど、

???このように、

メカと足がバラバラになって飛んでいる不思議な絵が出来あたりました。

空を飛んでいる人間をイメージしていたはずなのに、どこにメカ要素があったのか?

ウマ娘に対抗してウマ息子をやろうとしたらサタンになった。

これはこれでイケメンに仕上がる。

服はおかしな服も結構出てきます。

髪の色の指定が無いといろんな色で出てきます。

しかし、黒髪指定なのにカラフルな髪の毛が出来上がったり。なぜに?

ただ、何故か時折、油断している時に裸になろうとするのはいかがなものか?

露出度の高い奇抜な衣装をなぜ描く?普通の服は無いのか?

プロンプトに「裸」って入れてないはずなのにどうなっているのか?

高確率で耳にピアスが付いているのは何故なのだろうか?

牛乳風呂に入っている人発見!

なんで裸になりたがるのか?

AIも服書くのは面倒なのかな?

こういう時はネガティブプロンプトに「裸」「ピアス」などを入れておくと出現回数が減ります。

初めてでも結構できたので、できる環境がある方はやってみて。

いつか、AI画像集を出して売ろうかな。